El problema que el A/B Testing busca resolver es la Incertidumbre de Negocio. Muchas veces, el equipo de ingeniería despliega una funcionalidad técnicamente perfecta, pero que no logra los objetivos de conversión, retención o clics esperados. El A/B Testing elimina las opiniones subjetivas («creo que el botón verde es mejor») y las sustituye por significancia estadística.

La Anatomía del Experimento

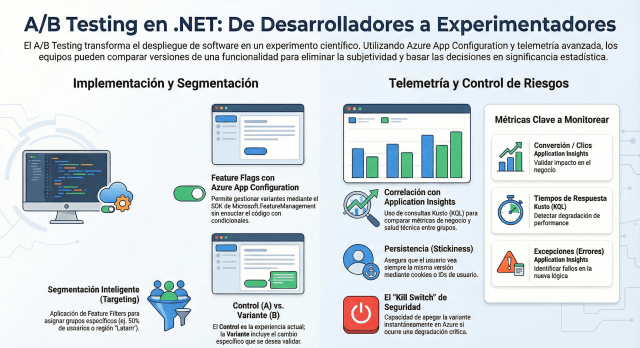

En un despliegue A/B, presentamos dos versiones (o más, en el caso de tests multivariados) a grupos de usuarios segmentados simultáneamente.

- Versión A (Control): La experiencia actual.

- Versión B (Variante): La nueva propuesta con un cambio específico (un nuevo algoritmo de recomendación en .NET, una interfaz de checkout distinta, etc.).

Implementación Técnica en Azure y .NET

Para ejecutar esto con éxito sin ensuciar el código fuente con cientos de condicionales if/else, utilizamos herramientas de Feature Management.

- Azure App Configuration: Esta es la pieza central. Utilizando el SDK de Microsoft.FeatureManagement para .NET, podemos definir «Feature Flags» que no solo se apagan o encienden, sino que se gestionan mediante Feature Filters.

- Segmentación por Target: Podemos configurar Azure para que el 50% de los usuarios autenticados vean la versión B, o filtrar por atributos específicos (ej. usuarios de la región «Latam» o usuarios con suscripción «Premium»).

- Client-Side vs Server-Side: En aplicaciones .NET (como Blazor o ASP.NET Core), podemos decidir si la lógica del test se ejecuta en el servidor antes de renderizar la vista o si enviamos ambas opciones y dejamos que el cliente decida basándose en una cookie de asignación.

El Rol de la Telemetría: La Verdad Única

Un A/B Testing sin datos es solo un despliegue Canary mal ejecutado. La clave aquí es la correlación. En Azure, conectamos nuestras Feature Flags con Application Insights.

Cuando un usuario entra en la «Variante B», marcamos su sesión con una propiedad personalizada (Custom Property). Luego, mediante consultas en Kusto (KQL), comparamos métricas:

- ¿El grupo B tuvo un tiempo de respuesta más lento?

- ¿El grupo B completó más transacciones en la base de datos SQL?

- ¿Hubo un incremento en las excepciones TaskCanceledException en la nueva lógica asíncrona?

Notas

- Aísla las Variables: No pruebes 10 cambios a la vez en la versión B. Si el rendimiento cae, no sabrás si fue por el cambio en el CSS o por la nueva consulta de LINQ optimizada.

- Cuidado con la Persistencia: Asegúrate de que un usuario que entró en la Versión B siempre vea la Versión B mientras dure el test (Stickiness). En Azure, esto se maneja mediante cookies o el ID del usuario en App Configuration.

- Define el «Kill Switch»: Si la variante B muestra una degradación crítica en métricas de salud (no de negocio), tu sistema debe tener la capacidad de apagar el experimento instantáneamente sin necesidad de un nuevo despliegue.

Conclusión

El A/B Testing eleva el rol del desarrollador .NET. Ya no solo eres responsable de que el código sea eficiente y escalable, sino de participar activamente en la validación de las hipótesis de negocio. En el mundo de 2025/2026, la agilidad no es solo desplegar rápido, sino aprender rápido qué es lo que realmente aporta valor.

Implementar esta estrategia en Azure requiere una infraestructura robusta de observabilidad y un cambio de mentalidad: el despliegue es solo el inicio del experimento, no el final del ciclo de desarrollo.