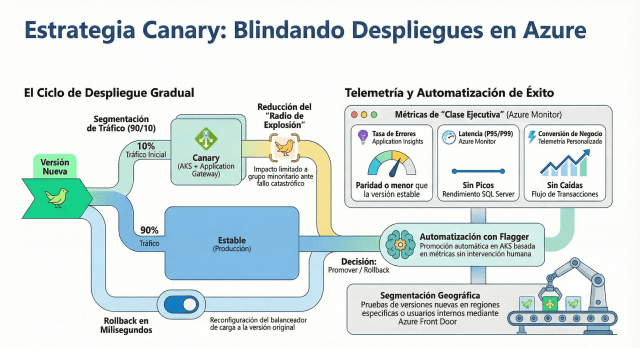

En el desarrollo de software de misión crítica, el mayor temor no es que el código no compile, sino que se comporte de forma errática bajo condiciones de tráfico real que el entorno de Staging no pudo replicar. El Canary Deployment soluciona el problema del «Radio de Explosión» (Blast Radius): si hay un bug catastrófico en la nueva versión de tu API en .NET, prefieres que afecte al 5% de tus usuarios (los «canarios») y no al 100%.

La Lógica de los Porcentajes y el Enrutamiento Inteligente

A diferencia de otras estrategias, aquí el control no está solo en el despliegue de los contenedores, sino en el Ingress Controller o el Service Mesh. En un clúster de Azure Kubernetes Service (AKS), utilizamos herramientas como SMI (Service Mesh Interface) o el Application Gateway Ingress Controller (AGIC) para dividir el tráfico de forma granular.

Imagina que despliegas una nueva versión de tu servicio de procesamiento de pagos escrita en .NET 10. Inicialmente, configuras Azure para que el 90% del tráfico siga en la versión estable (Stable) y solo un 10% vaya a la nueva versión (Canary). Durante este periodo, no solo miras si la aplicación está «viva», sino que comparas métricas de negocio y telemetría avanzada mediante Azure Monitor y Application Insights.

El Rol Crítico de la Telemetría en .NET

Para que un Canary Deployment sea exitoso en el ecosistema Microsoft, la telemetría debe ser de «clase ejecutiva». No basta con saber que la CPU está al 40%. Necesitas comparar:

- Tasa de Errores (Error Rate): ¿El 10% de los usuarios en la versión Canary está experimentando más excepciones que el grupo estable?

- Latencia (P95/P99): ¿La nueva versión es más lenta al procesar peticiones a SQL Server?

- Métricas de Negocio: ¿Ha caído la tasa de conversión de carritos de compra en la versión nueva?

Si los datos son positivos, aumentas gradualmente el tráfico (25%, 50%, 75%) hasta completar la migración. Si algo sale mal, el «Rollback» es simplemente una reconfiguración del balanceador de carga, devolviendo al 100% de los usuarios a la versión segura en milisegundos.

Notas

- Automatiza el «Análisis de Canario»: No dejes que un humano decida si el canario está sano. Usa herramientas como Flagger en AKS para automatizar la promoción de la versión basándose en métricas de Prometheus o Azure Monitor.

- Segmentación Inteligente: No siempre el 10% debe ser aleatorio. En Azure Front Door, puedes dirigir el tráfico «Canary» basándote en la región geográfica o en headers específicos para probar primero con usuarios internos.

- Manejo de Base de Datos: Al igual que en Blue-Green, tu esquema de base de datos debe soportar ambas versiones. El Canary durará más tiempo conviviendo con la versión vieja, por lo que la compatibilidad hacia atrás es obligatoria.

Conclusión: La Evolución hacia el Análisis Predictivo

El Canary Deployment transforma el despliegue de un evento de infraestructura a un experimento científico. Es la estrategia ideal para equipos que operan con microservicios altamente desacoplados y que utilizan Feature Flags (vía Azure App Configuration) para complementar la seguridad del despliegue.

Adoptar Canary en Azure (usando Azure DevOps Pipelines o GitHub Actions) requiere una inversión inicial en automatización y observabilidad, pero el retorno es la tranquilidad total. Ya no despliegas rezando para que funcione; despliegas sabiendo que tienes el control total sobre quién ve qué, y con la capacidad de apagar el riesgo antes de que se convierta en una crisis pública.